國際政策趨勢

使用人工智慧來輔助醫療照護決策—給社會大眾的指南(3)

由韓國政府於1971年所設立的韓國高等科學技術學院(Korea Advanced Institute of Science and Technology, KAIST)中的韓國第四次工業革命政策中心(The Korea Policy Center for the Fourth Industrial Revolution, KPC4IR),在8月份時發布了《 使用人工智慧來輔助醫療照護決策──給社會大眾的指南》(Using AI to Support Healthcare Decisions: A Guide for Society)。透過裡面提出的幾個問題,可以幫助社會大眾更了解AI,使AI應用的推行能更為順利,造福社會。以下翻譯自該指南。

AI對於患者和疾病做出了何種假設?

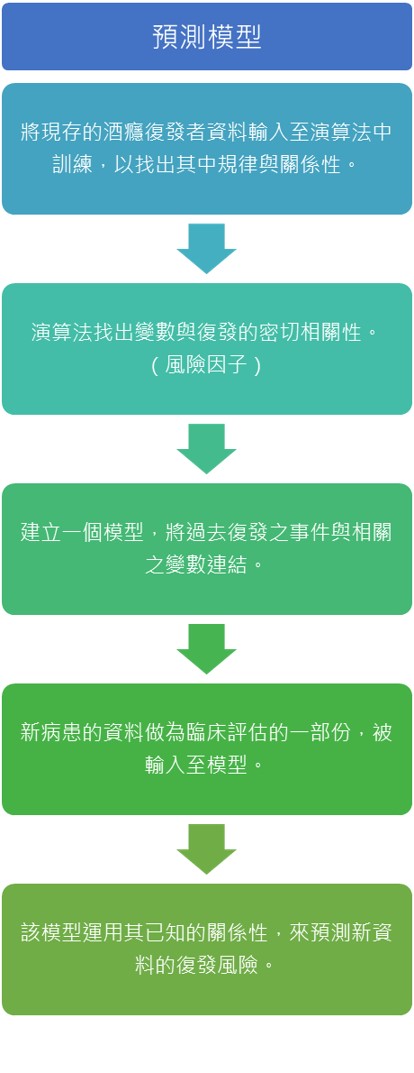

假設分析酒精成癮復發者資料的演算法發現,在低收入戶的復發率較高,其有可能將收入下降做為復發的一個風險因子。在變數間的關係資訊可以用來建立一個預測模型,一個運用過去已發生事件之資訊,來預測未來可能發生之事件的數學方程式。(如下圖)

模型如何轉化到現實世界運用,會影響到AI的可靠性、通則性和公平性。

而這其中需要思考到的幾個重要的面向為:

- 是否掌握到正確的關係性?

- 從模型中剔除的變數是否真的為不相關資料?

- 結果是否具有通則性?

- AI是否能消除人類在決策中所產生的偏見?

是否掌握到正確的關係性?

有時候觀察性資料表現出的變數似乎是互相關聯的(當一個數值上升,另一個也上升或是下降),這些變數是有關聯的,但不代表其中一個是另一個的「成因」。

2017年,芝加哥大學醫學中心開發了一個預測病患住院時間的AI,其目的為幫助醫師判斷哪些病患症狀較輕能較快出院,以增加病床的週轉率。該AI的演算法發現病患的郵遞區號是預測住院時間的最佳因素之一,住院時間較長的病患大多來自較貧困的地區。因此,AI建議讓來自富裕地區的病患先行入院。郵遞區號與住院時間有著明顯的關聯,但是一個人的居住地區不太可能是其住院時間較長的原因。

從模型中剔除的變數是否真的為不相關資料?

現實世界裡包含了數百萬個在同時間變化的變數,一個模型不可能解釋到每一種可能的變化程度。一些變數可能唾手可得;而另一些變數可能成本高昂,甚至難以取得。電腦的處理能力限,可以花費的時間和金錢也有限。所以,資料科學家事先做出假設,並刻意將一些變數除外。

在芝加哥醫學中心的例子中,開發者需要考慮到缺失的變數。或許有第3個因子在發揮作用,而這個因子影響著病患住院的時間。在這種情況下,貧困的人民居住在其負擔得起的地方,這也導致其健康狀況下降,罹患慢性病的風險上升。貧困對於健康的不良影響可能會因一項,將更多醫療資源從病患身上轉移出去的技術而變得更為嚴重。

任何使用AI技術的人都應該確認,該模型中可能缺少了哪些變數,為什麼會缺少這些變數,而這又會對結果產生什麼影響。而開發商更是需要了解這一點,並誠實地與其將要轉移技術的人員進行討論。

結果是否具有通則性?

AI無法在跟其訓練資料(用於開發AI的資料)差異度很大的領域,進行預測或是建議。

在VUNO Med-BoneAge的例子中,該AI輔助診斷工具其訓練資料是建立在韓國國民之上,並使用了多國資料進行驗證。由於生長曲線會因種族與民族不同而有所不同,在使用其他國家的人口資料時,VUNO Med-BoneAge的準確度亦有可能有所不同。在這個情況下,為了使輸出結果在高加索人種、美國原住民、非洲人中更為精確,有必要將演算法進行微調或是再訓練。

可能影響AI通則性的變數,包含了年齡分布、種族、性別、地理位置和氣候。任何使用AI產品的人都應該了解,其產出的結果是否具有通則性,且臨床醫師應該對AI所提出之治療建議的準確度保持著信心。

AI是否能消除人類在決策中所產生的偏見?

一個關於AI輔助決策工具常見的謬誤,就是它是冰冷但毫無偏見的。不過,AI是依據現實世界的資料來訓練的,它看到的是世界原本的樣子,而不是包裝過的理想世界。AI本身不具有好壞之分,但除非開發者了解資料之侷限性,不然其將有可能加劇醫療資源分配不均的問題。一些研究人員試圖透過其程式碼,來解決現存的偏見問題。

如果盲目地提高病床週轉率是使用該AI的唯一目標,那麼將郵遞區號做為代表,預測誰該優先被治療,看起來似乎也不是那麼糟糕。但是在芝加哥大學醫學中心所遭遇的問題是,住在貧困地區的民眾,美國黑人占了大多數。AI透過將醫療資源從貧困地區的民眾身上轉移,將加劇美國社會現有的種族健康不平等現象。

即使是具有代表性的資料,其亦有可能暗藏偏見、偏差、具有危害的假設。在這複雜的現代社會,AI所做出的預測和建議都脫離不了社會現實,任何使用AI輔助決策的人或是在醫療領域中的任何決策,都應該思考其是否有能力改寫偏見。

評論者或是病患可以詢問,假設AI在技術上完成了它的工作,但是我們要如何確定它做出的預測是公平的呢?

這並不意味的有哪個群體必須比另一個群體,還要關注如何使用AI來輔助其治療。當我們在正確的時間進行了正確的對話時,每位參與者都可以對臨床上做出的決策抱持信心。

使用人工智慧來輔助醫療照護決策—給社會大眾的指南(1)

使用人工智慧來輔助醫療照護決策—給社會大眾的指南(2)

使用人工智慧來輔助醫療照護決策—給社會大眾的指南(4)