國際政策趨勢

你所見不一定為真--AI與DeepFakes(上)

AI的預測功能如此強大,不僅可以用來預測明天天氣、行為模式、圍棋落點......還可以用來預測你的語氣、表情以及衣服下面的身材。聽起來遙遠嗎?其實這樣的技術已經大有人在。你可以不懂AI技術,但你一定要了解DeepFakes,否則下一個被騙去銀行存款的可能就是你。本文摘譯英國資料倫理與創新中心(Centre for Data Ethics and Innovation; CDEI)今年九月之報告,分為上下篇以利我們能迅速掌握與之相關的問題。

全文摘要

- Deepfakes 可以定義為經過軟體處理後,人、環境、物體受到改變的聲音或影像。

- Deepfakes 已變成臉部替換的同義詞,亦即將照片中的人臉替換為他人,最早被利用在色情影像中。

- Deepfakes也有以下形式

1. 臉部再製(face re-enactment):更改一個人臉部的特徵,而不換成另一個人的臉。

2. 人臉生成(face generation):利用軟體生成一張全新的臉,並不參考任何真實人物。

3. 聲音合成(speech synthesis):生成某人的聲音。 - Deepfakes在未來極有可能發展的更成熟。然而就現階段來說,生出高品質的內容仍是非常困難,需要極為專業的技術和軟體,而這些軟體目前尚未普及,所以市面上尚未出現足以混淆大眾視聽的deepfake產品。

- 即使是發展中的deepfakes也可能造成傷害,據估計目前有上千部的deepfake色情影片在網路上流竄,造成受害者不小的傷害。

- 「shallowfakes」的發展值得擔憂,這個詞是指利用基礎的技術更改少許的影音內容,例如標題、語速來混淆閱聽者。

- 單用法律不足以限制deepfakes和shallowfakes,我們仍需要發展保護機制來過濾違法的影音內容,並且讓大眾了解這種加工影像的存在。

- 不論用什麼方法管理這些加工影像的散布,政府和立法機關必須小心不要抑制其他良性的發展,例如娛樂和行銷上的應用。

- 不實資訊,特別是「假新聞」,已經成為了舉世皆知的現象,各界專家都針對這個問題做了不少評論和建言。社會大眾過去最關心的是被加工的新聞、網路文章及網軍,然而隨著deepfake的出現,我們正面臨著全新的挑戰。這篇文章我們將介紹deepfakes的特性,它對社會的風險,以及未來可能的應用。

什麼是Deepfakes?

「Deepfakes」這一詞最早從2017年開始被矚目,Reddit上一名ID為deepfake的用戶在網路上張貼了一系列的加工色情影片,他將色情影片中的臉更改為各種名人,Reddit迅速成為了分享加工影片的核心。科技網路雜誌Motherboard當年甚至下了「AI色情影片來了,我們完蛋了」的標題。

Deepfakes可以被定義為經過先進的軟體處理後,人、環境、物體受到改變的聲音或影像,主要有以下四種型態:

臉部替換:使用某人臉部的影像,替換掉另一個目標人物的臉,目標人物的臉被覆蓋了,重點在換上去的臉。

.png)

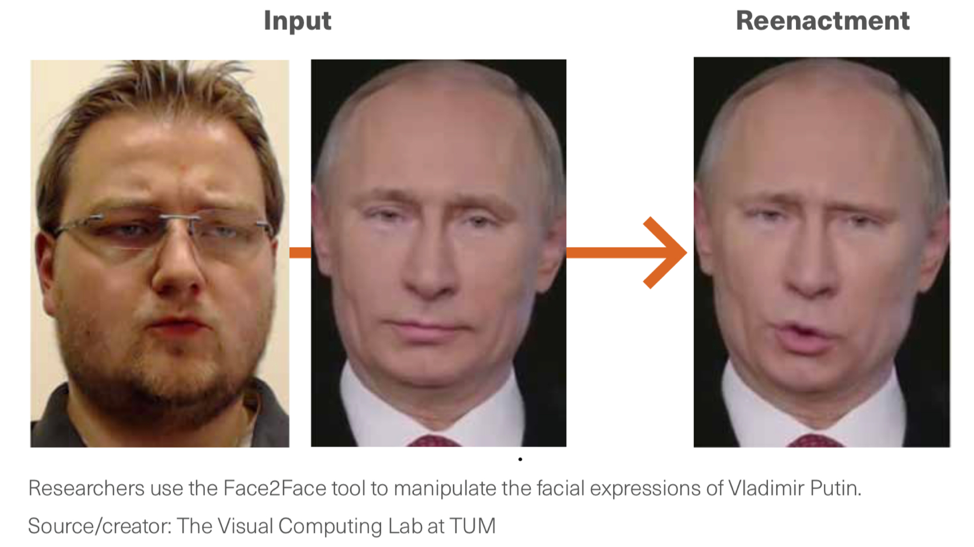

臉部再製:這類型的技術可以修改目標人物的臉部表情,例如移動他們的嘴巴、眉毛和眼睛,臉部再製的目標並不是取代他們的臉部特徵,而是更改他們的面部細節來使照片傳達的訊息不同。

人臉生成:這項技術能夠創造一個全新的臉,是利用一種新興的「GAN」(生成對抗網路)深度學習技術,這種技術使用兩個神經網路互相對抗,其中一個生成影像,另一個負責判斷生成的影像是否夠好。

聲音合成:deepfakes中一種相對新的分支,聲音合成可以創造一個人聲音的模型,使用那個人的說話方式和語調唸出文字。而有的聲音合成產品,例如Modulate.ai,則是能讓使用者挑選聲音的年紀和性別,並不是模仿某個特定的目標。

每種型式的deepfake都有他們的極限,臉部再製可以保持一個人臉部的特徵不變而使照片看起來更加逼真,但就目前來說,目標影像不能太巨幅的移動而且必須面對鏡頭(例如政治人物發表演講的影像就是適合的目標)。臉部替換則需要分別取得目標和素材兩個人各種不同角度的影像。在聲音合成技術成熟以前,臉部再製和臉部替換都需要有專人配音,然而聲音要與影像同步並不是一件簡單的事。

了解這四種形式deepfakes的不同以及製作他們所需要的工具是很重要的,Snapchat的功能可以簡單的達到臉部替換的效果,而Face2Face則是用來做臉部再製的。隨著新的工具不斷出現,deepfake的品質將會越來越好,種類也會越來越多,雖然這篇文章只著重於臉部和人聲的合成,但任何影像和音訊在理論上都是可以被操控的,包括背景的景色或是身體的移動。

Deepfakes是如何被創造的?

操控影像並不是一項新的技術,從很早以前人們就在進行各種修圖和製片,最早的臉部替換可以在林肯和一名南美的政治家Calhoun的照片上看到,林肯的頭被替換到了Calhoun身上。但最近幾年開始有先進軟體技術的出現,例如機器學習演算法,讓產生deepfakes變得更快更簡單。同時這些技術也已經被商業化並透過FakeApp和Face Swap這類的軟體進入主流市場。

關於臉部替換的研究,開發者Alan Zucconit列出了他們的三個主要步驟:蒐集(extraction)、訓練(training)、創造(creation)

蒐集:第一個工作是蒐集足夠的圖像來訓練臉部替換模型,一個常見的方法是從素材和目標人物的影片中獲得,將影片切成一幀幀的圖片,並將圖片裁切到只剩下臉部,這個過程可以利用一些程式或軟體完成。

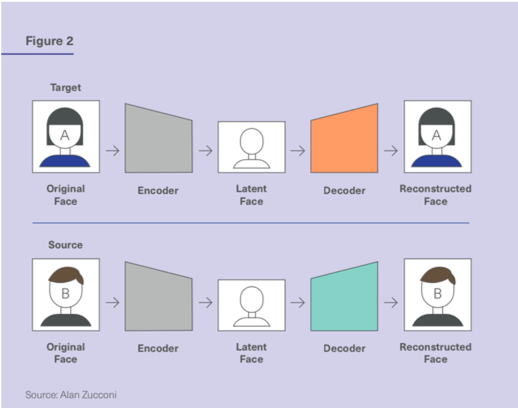

訓練:第二個步驟是利用蒐集到的圖像資料開始訓練模型,這個步驟可以使用自動編碼器(autoencoder)來完成,自動編碼器是一種類神經網絡,他有兩個部分:「編碼器」(encoder)和「解碼器」(decoder)。編碼器將圖像壓縮,以較低的維度來表示圖像。而解碼器則將壓縮過後的圖片還原成本來的樣貌。

.png)

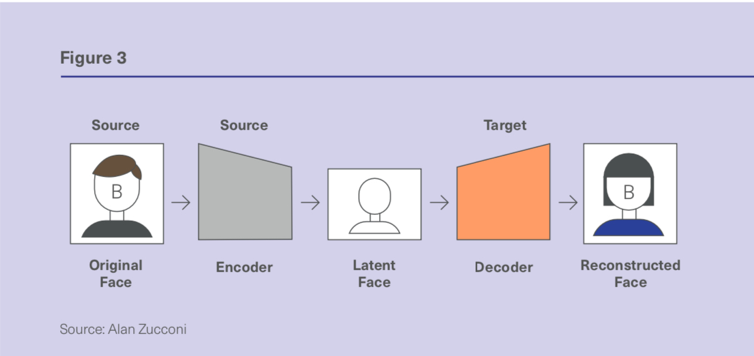

當兩個神經網路都訓練完成後,將解碼器互換,這可以讓素材圖片以原本的編碼器壓縮,但用目標圖片的解碼器還原,巧妙的將素材圖片的臉換成目標圖片的臉,臉部的表情卻和目標圖片相同。臉部替換藉由訓練這兩個不同的類神經網路來完成(一個處理素材的臉,另一個處理目標的臉),兩個類神經網路使用相同的編碼器,這使得處理解壓縮的圖片時能夠有相同的基準。相反的,這兩個類神經網路使用不同的解碼器,他們各自進行訓練直到能夠還原出本來的圖像為止。

創造:這是技術上最困難的步驟。要將前面製作出來的臉部圖像嵌入到目標影片中,這過程必須確保臉合成的角度和影片中是相符的,根據Zucconi的說法,這是唯一一個需要手寫演算法而不是僅靠機器學習演算法的步驟,也因此這個步驟經常會發生錯誤。

臉部再製是另一個常見的deepfake形式,也是使用自動編碼器運作。然而這種應用只需要單一影片,不需要取得多個目標的圖像。

(編譯者:黃則普)

下篇:https://www.aili.com.tw/message2_detail/55.htm